博鱼官方下载

博鱼官方下载

大言语模子的「母语」是什么?

咱们的第一响应很可能是:英语。

但事实果然如斯吗?尤其是关于能够传闻读写多种言语的LLM来说。

对此,来自EPFL(洛桑联邦理工学院)的盘问东说念主员发表了底下这篇使命来一探究竟:

作家以Llama2为对象,向咱们展示了具有多言语时期的Transformer,是怎样念念考问题的。

像「羊驼」这种在英语区下长大的娃,他的「多言语」到底是本色属性,已经只是套了个翻译的壳?

这关于东说念主们融会LLM的运行机制至关遑急。

要探究大模子的内心寰宇,诚然听起来有点复杂,但本质上小数也不粗拙。

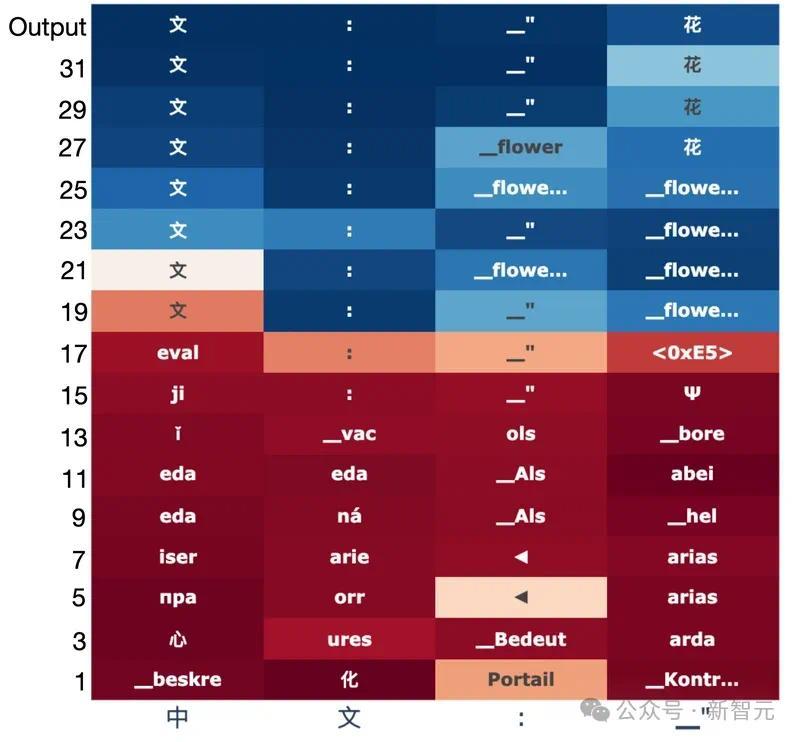

盘问东说念主员在这里化繁为简,使用特定的领导来保证输出的唯独性,同期把Llama-2-7B的32层输出一起索要出来——一层一层一层的剥开她的心。

于是,咱们能在上图明晰地看到,羊驼在取得汉文翻译(「花」)时的系数这个词推理历程。

Transformer将输入token进行逐层映射,最终酌量出下一个token,中间那些咱们大约能融会或者不成融会的字符串,即是LLM使用的「里面言语」。

彰着,在中间层的「念念考」才能,羊驼用的是偏向于英语的某种深邃笔墨。

这里需要强调一下,这是羊驼的自觉行为,因为领导中根底就莫得小数英语!

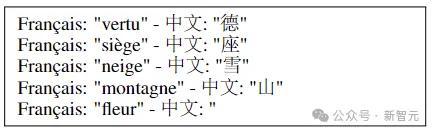

比如上图是其中的一个实验,构建了法语翻译汉文的领导,且纵容了正确谜底只需1个token(花)。

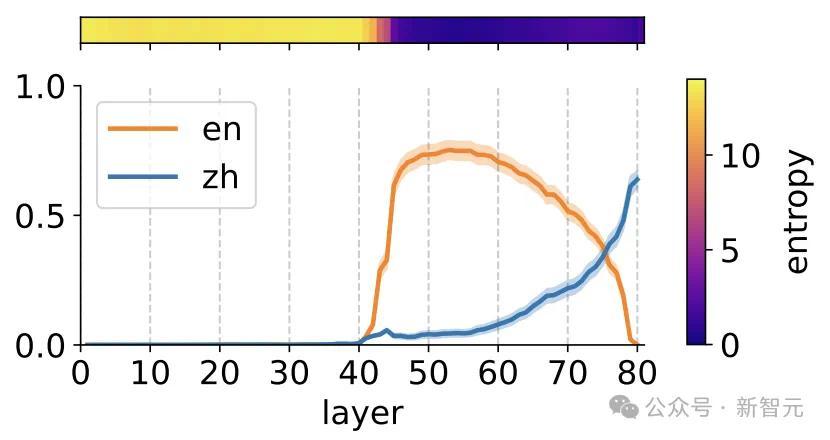

而下图的统计走漏:在Llama2的大部分前向传递中,正确汉文token(蓝色)的概率远低于英文翻译(橙色)的概率。汉文只在终末两层中占据主导地位。

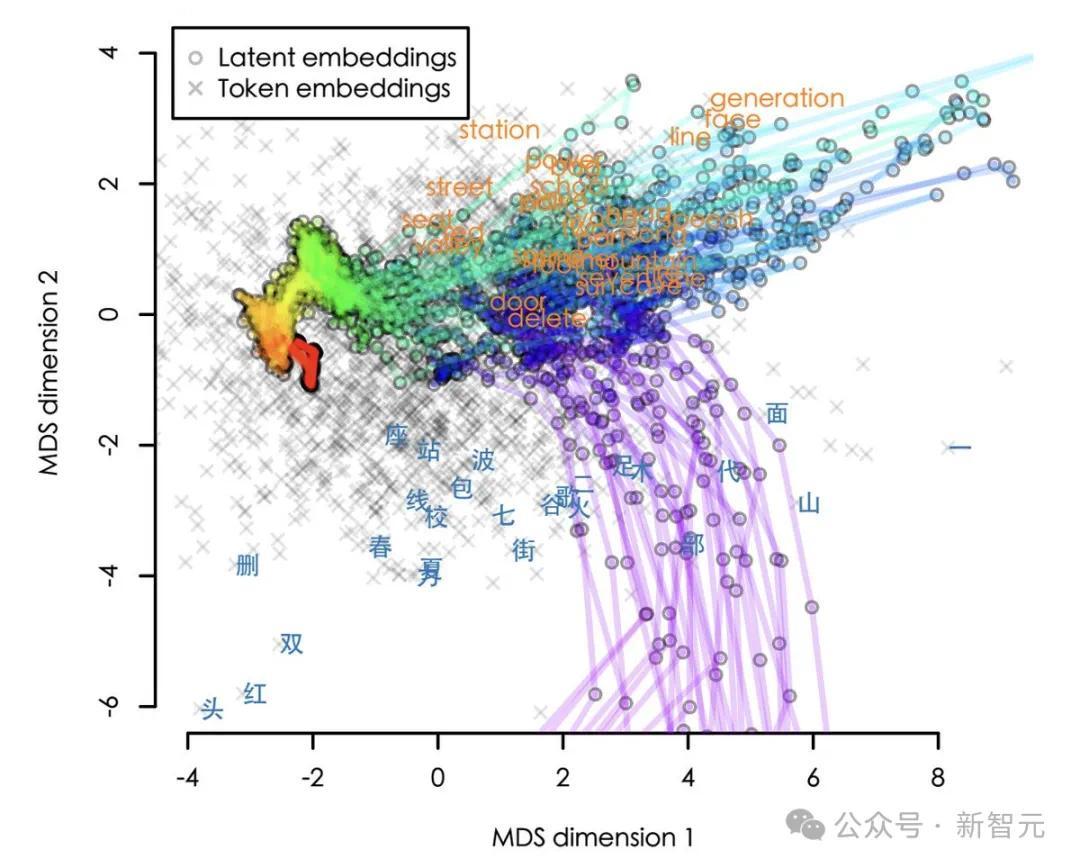

为了肤浅公共不雅察,作家还将镶嵌在高维空间中的旅途的可视化(本质是8192个维度,这里使用2D展示)。

从输入到输出,轨迹以红色运转,以紫色终结。咱们不错看到,这些旅途基本齐是先绕说念英语,然后才复返正确的汉文。

不外,这是否如实标明Llama2先用英文进行推理,然后将再其翻译成汉文?

作家暴露,比这更高明小数。那些看起来像英语的中间镶嵌本质上对应于详尽主张,而不是具体的英文token。

是以,一方面,Llama2里面的「通用语」不是英语,而是主张;

但另一方面,这些深邃字符又彰着是偏向于英语的主张。

因此,在语义上,而非合法的词汇意旨上,英语如实不错被视为羊驼的「母语」。

网友:我早就发现了

有网友暴露:恕我直言,不单是是羊驼系列,基本上系数LLM齐是这么。

「关于以英语为母语的东说念主来说,这可能会令东说念主骇怪,但关于其他东说念主来说,这种倾向性是可见的,只不外巧合多,巧合少。」

「巧合我会想LLM为什么要这么回报,然后我意志到这个谜底在英语中更特殊旨。」

「这在诗歌中更是不问可知的。LLM写诗很漂亮,但频频莫得押韵.——如果你把它翻译成英语,就押韵了。」

另一位网友暴露,这是大模子带来的偏见,要防御了。

「英语和汉文最终将成为LLM领导和输出的最好言语,而跟着LLM的期骗限制越来越世俗,寰宇其他言语将愈加边际化。」

1

模子抒发空间的探索

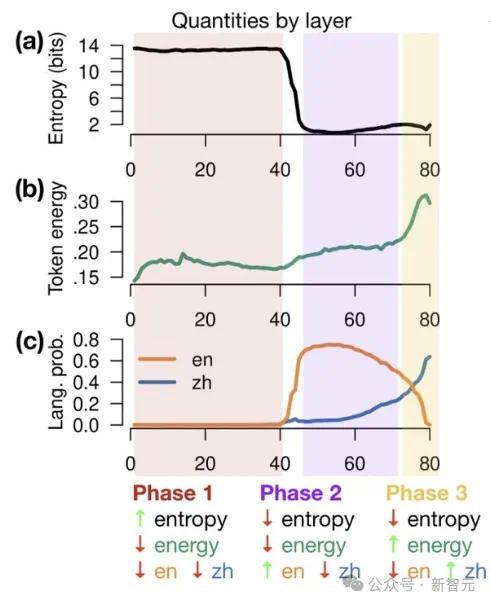

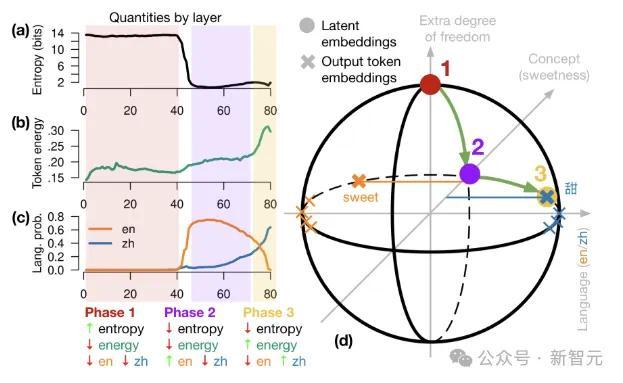

当镶嵌逐层转换时,它们会阅历3个阶段:

1. 输入空间:模子排斥分词器带来的影响。

2. 主张空间:镶嵌投入一个详尽的主张空间中。

3. 输出空间:主张被映射回原来的抒发表情。

模子

实验专注于Llama-2系列言语模子。Llama-2系列模子在多言语语料库上进行查验,语料库主要由英语主导(占89.70%)。

不外谈判到总体查验数据的大小(2万亿个token),即使是一小部分非英语查验数据,统统值仍然很大(德语占0.17%=3.4B,汉文占0.13%=2.6B)。

Llama-2有7B/13B/70B三种尺寸,诀别为32/40/80层,镶嵌维度d=4096/5120/8192,词汇表V包含32,000个token。实验中使用8位量化探究这三种不同大小的模子。

实验

实验的贪图是探索Llama-2的里面现象,是否与特定的当然言语相对应,这需要从token散播映射到言语。

为了回避很多token在言语方面上切肉脸皮的问题,盘问东说念主员构造了特殊的领导,纵容token输出的唯独性,况兼不错明确地归因于某一种言语。

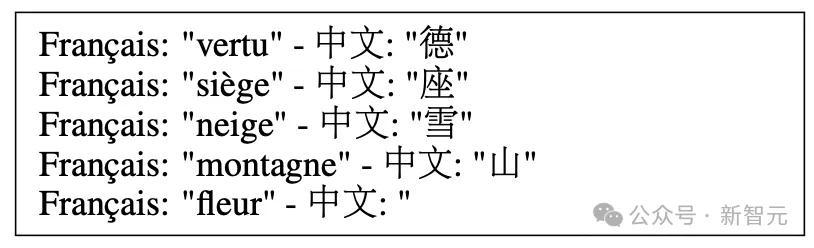

翻译任务

将前边的非英语(举例法语)单词翻译成汉文,示举例下,向模子展示四个单词,并带有正确的翻译,后跟第五个莫得翻译的单词,让模子酌量下一个token:

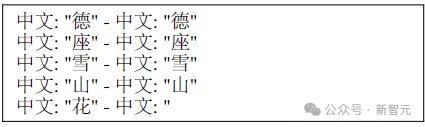

访佛任务

条目模子粗拙地访佛终末一个单词,领导如下:

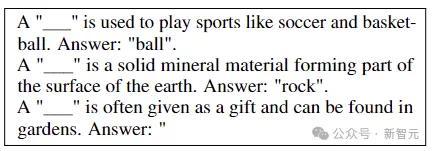

完形填空任务

算作一项稍许梗阻的任务,模子需要酌量句子中缺失的单词。给定一个贪图单词,通过GPT-4构建一个以该单词开头的英语句子,屏蔽贪图单词,并将该句子翻译成其他言语。英语示举例下:

单词选拔

为了达成明确的言语包摄,盘问东说念主员为每种言语构建了一组阻滞的单词。扫描Llama-2的词汇表,寻找具有单token英文翻译的单token汉文单词(主若是名词)。

这么一来,Llama-2酌量下一个汉文单词的正确概率就不错获胜从下一个token概率中读出。

保障起见,作家还在德语、法语和俄语上进行了沟通的实验,系数测试了139个汉文、104个德语、56个法语和115个俄语单词。三个任务的测试效用如下:

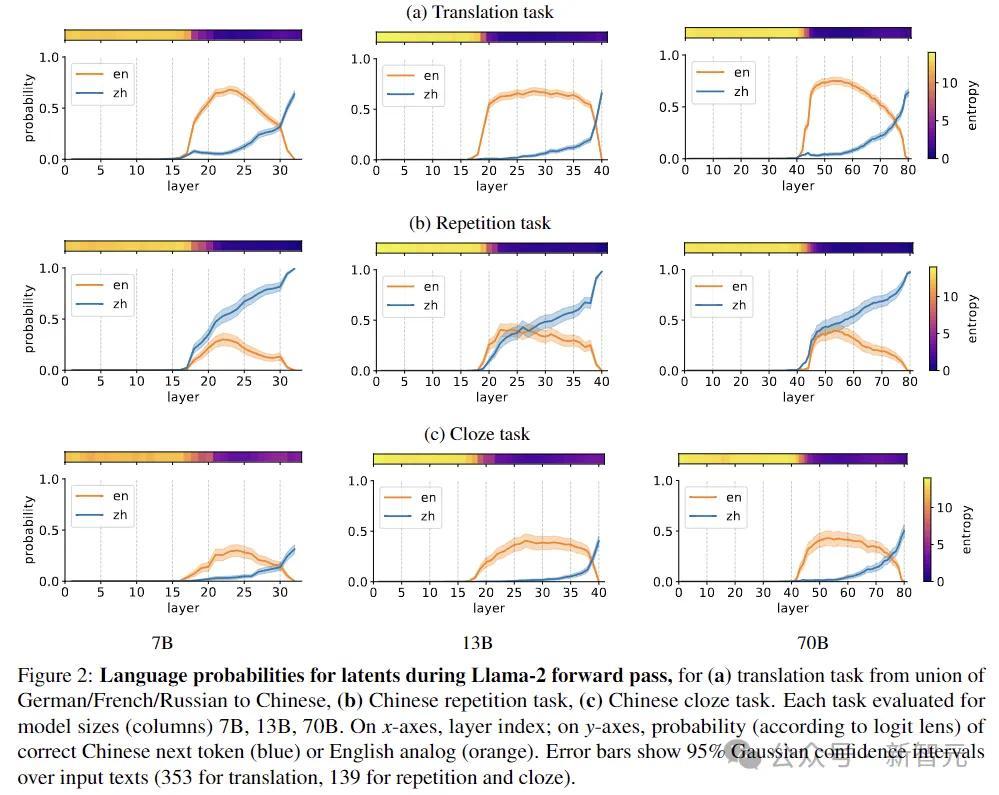

上图暴露Llama-2前向传递时分,每一层输出是英语已经汉文的概率,三个任务诀别为:(a)从德语/法语/俄语到汉文的翻译任务,(b)汉文访佛任务,(c)汉文完形填空任务。

舛错线走漏输入文本的95%高斯置信区间(翻译任务为353,访佛任务和完形填空为139)。

8192D天际漫游

自回来Transformer是以增量模式求解的,每一层通过添加残差来修改前一层产生的潜在向量,这一历程在几何上不错描摹为通过d维欧几里得空间的旅途。

为了建树直观,率先谈判一个假定的极点情况,即token位于系数这个词d维空间的合适子空间中。

如果latent embedding(h)具有与token子空间正交的重量,则暴露酌量中包含与h无关的信息。

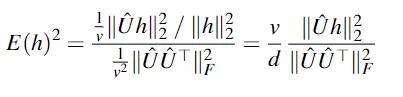

盘问东说念主员选定h和token镶嵌之间的均方余弦,来暴露h的能量有几许升沉为logit分数。为了可讲授性,这里通过token镶嵌自身的均方余弦进行归一化,取得h的日常token能量:

在上头的球形暗示图中,系数镶嵌齐位于原点周围的球体上。token镶嵌位于赤说念上,主要沿x轴散播,x轴拿获言语(左英文,右汉文),y轴捕捉主张,z轴提供了独特的目田度,可用于存储相干潦倒文、言语等的信息。Transformer正向传递沿球体名义出动。

在第1阶段,latent embedding从北极运转,与输出token和主张镶嵌正交。

阶段2旋转到主张空间中,英语token占据主导。

终末,第3阶段沿赤说念旋转到贪图言语的半球博鱼官方下载,产生输出token。